rrimyuu 님의 블로그

Paper review | Finding the Right XAI Method—A Guide for the Evaluation and Ranking ofExplainable AI Methods in Climate Science 본문

카테고리 없음

Paper review | Finding the Right XAI Method—A Guide for the Evaluation and Ranking ofExplainable AI Methods in Climate Science

rrimyuu 2024. 8. 26. 16:321. Introduction

- 기후 과학 분야서 널리 사용되는 deep learning

- But, 의사결정 과정 이해 어려운 deep neural network

- 높은 예측 성능 뿐만 아니라 기존 이론과 일치하는 예측 이유 제공하는 DNN 필요

- 해석 불가능성 문제를 해결하는 explainable AI

-

Ante Hoc method vs. Post Hoc method

-

DNN architecture 수정 필요한 Ante Hoc method-> Self-explaining neural networks

-

But, 모든 NN 에 적용 가능한 Post Hoc method

- 설명 대상 기준: Local vs. Global

- 설명 산출시 사용 요소 기준: Model aware method vs. Model agnostic method

- Model aware method: trained model 구성 요소 (neural network weights ...) 를 설명 산출에 사용

- Model agnostic method: input parameter 변동으로 인한 출력 변화를 설명 산출에 사용 - 픽셀 영향 기준: Sensitivity method vs. Salience method

- Sensitivity method: 픽셀이 네트워크에 얼마나 민감한가

- Salience method: 픽셀이 클래스 예측에 얼마나 긍정적 or 부정적으로 기여하는가 - 현실서 XAI 적용 어려움 및 모델 동작 근사치 불과한 Post hoc methods

- 따라서, 기후 과학 맥락서 XAI 평가 도입 후 다양한 Local methods 비교.

- Robustness, Complexity, Localization, Randomization and Faithfulness 통한 정량 평가

2. Data and methods

2.1. Data

- Data simulated by the general climate model, CESM1 (Hurrell et al. 2013), focusing on the “ALL” configuration

- The global 2-m air temperature (T2m) maps from 1920 to 2080.

- The data (ohm) consist of I=40 ensemble members and each member is generated by varying the atmospheric initial conditions (z_i) with fixed external forcing (theta_clima)

2.2. Networks

- Train an MLP with network weights to solve a fuzzy classification problem by combining classification and regression

- The network considers the flattened temperature maps with dimensionality d = y x h.

- 각 지도를 1900년부터 2100년 사이의 20개 클래스 중 하나에 할당함. 회귀를 사용하여 입력에 대한 연도를 예측함. (ex. 1920-1929년대를 1925, 해당 10년 단위 클래스의 중앙 연도)

2.3. XAI (local model-aware explanation methods)

3. Evaluation techniques

3.1. Robustness

3.2. Faithfulness

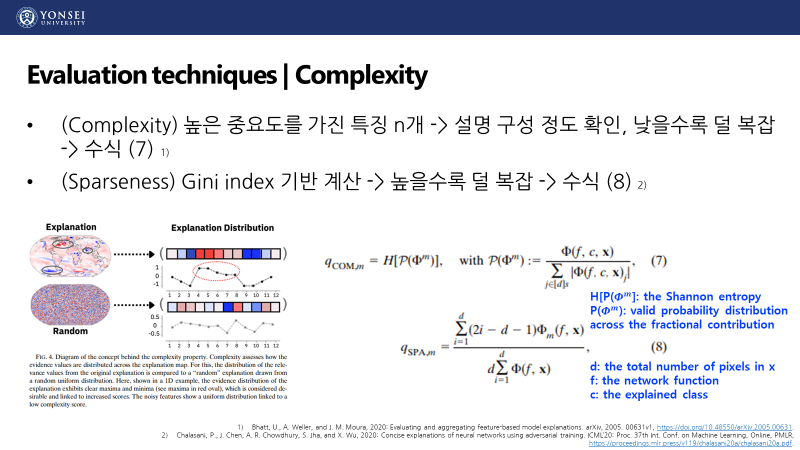

3.3. Complexity

3.4. Localization

3.5. Randomization

3.6. Metric score calculation

4. Experiments

4.1. Explanation disagreement

- 동일한 네트워크 예측을 설명하더라도, 서로 다른 방법이 동일한 영역에 서로 다른 중요성 값을 할당하여 XAI의 불일치 문제를 드러냄.

- DeepSHAP, LRP-z 가 제공하는 explanation map 에서 상반된 중요성 부호를 표시하여 시각 비교 및 해석을 방해했음.

- 부호의 차이는 DeepSHAP 이 특징 제거와 수정된 기울기 역전파를 기반으로 하는 반면, LRP-z는 이론적으로 입력과 기울기 곱에 해당하기 때문일 수 있음.

- 두 설명은 네트워크 결정의 서로 다른 측면을 표시할 가능성이 있고 입력 이미지에 따라 설명의 부호가 달라질 수 있음.

4.2. Skill scores based on the random baseline reference for two different metrics in each

- sensitivity methods (violet tones) / salience methods (earthy tones)

- (Robustness) 모든 XAI 방법에서 average sensitivity, local lipschitz estimate 가 유사함. 전체적으로 local lipschitz estimate 가 더 높은 값을 나타냄.

- (Faithfulness) 모든 XAI 방법에서 ROAD 점수는 양의 점수를 나타내는 반면 faithfulness correlation 은 음의 점수를 포함함.

- 민감도 맵은 각 픽셀 값의 변화에 대한 네트워크의 민감도를 나타내며 마스킹 값의 영향은 원래 픽셀 값과 마스킹 값 간의 불일치에 따라 달라지므로 이는 음의 상관관계를 초래함.

- sensitivity methods 는 전반적으로 낮은 skill scores 를 보임.

- DeepSHAP 은 낮은 faithfulness correlation 을 보임. 이는 Shapley 값을 연속 데이터에 적용하는 데 어려움 및 특징 상관성 (feature correlation) 에 대한 취약성 때문이라 추측. - (Complexity) 모든 XAI 방법에서 complexity 는 sparseness 에 비해 낮은 점수를 가짐. 이는 기후 데이터에 대한 설명이 무작위로 샘플링된 값과 유사한 엔트로피를 가진다는 것을 나타냄. 기후 데이터의 높은 변동성 및 낮은 신호 대 잡은 비율에 기인.

- (Localization) 북대서양 지역을 ROI 로 선택. 두 메트릭 (Top-K and Relevance Rank Accuracy) 모두에서 낮은 skill score 를 보임. 이는 Complexity 에서 낮은 Sparseness 점수와 일치함. 높은 중요성 값이 널리 퍼져 있으며 ROI 에서도 뚜렷한 특징이 적음을 나타냄. ROI 선택이 적절하지 않음을 나타낼 수 있음.

- (Randomization) 모든 XAI 방법에서 Random Logit 은 낮은 점수를 가짐. 연속 데이터의 차이가 작을 수 있어 네트워크 결정 및 다른 클래스에 대한 설명에 유사한 특징이 포함될 수 있음.

4.3. Network-based comparison

- MLP와 CNN에 대한 설명 방법의 성능을 비교하기 위해, 각 속성에 대해 하나의 메트릭을 선택.

-> 강건성(robustness)에는 로컬 리프시츠 추정(Local Lipschitz estimate), 충실성(faithfulness)에는 ROAD, 복잡성(complexity)에는 희소성(sparseness), 위치화(localization)에는 Top-K, 그리고 랜덤화(randomization)에는 모델 파라미터 랜덤화 테스트를 사용했음. - (Robustness) CNN의 경우, LRP 복합 규칙이 가장 뛰어난 강건성 스킬을 제공했음. 기여도(salience) 방법들이 약간 더 높은 스킬 점수를 보였으나, FusionGrad가 LRP-a-b와 DeepSHAP을 능가하는 예외도 있었음.

-> 이는 CNN과 MLP 사이에 학습된 패턴의 차이로 인해, 네트워크와 입력 교란을 모두 포함하는 것이 더 강력한 설명을 제공하며, DeepSHAP처럼 제거 기반 기법과 수정된 그래디언트 역전파를 결합하거나 LRP-a-b처럼 음의 기여 뉴런을 무시하는 방법은 다른 기여도 방법들에 비해 강건성을 악화시킨다는 것을 시사함. 더욱이, 입력 교란을 사용하는 설명 방법들이 CNN의 민감도 설명 강건성을 향상시키는 반면(SmoothGrad와 FusionGrad), 네트워크 교란만 사용하는 방법들은 강건성 스킬을 감소시킴(NoiseGrad). - (Faithfulness) 충실성 속성에서, 기여도 설명 방법(Integrated Gradients, input times gradient, LRP)은 두 네트워크 모두에서 더 높은 스킬 점수를 기록했으며, 이는 이전 연구 및 이론적 차이와 일치함. 그러나 LRP 복합 규칙은 예외적으로, 충실한 증거를 희생하여 덜 복잡하고 강력한 설명을 제공함.

- 교란 기반 설명 방법(SmoothGrad, NoiseGrad, FusionGrad, Integrated Gradients)은 MLP의 Integrated Gradients를 제외하고는 기본 설명(gradient 및 input times gradient)과 비교하여 충실성 스킬을 크게 향상시키지 못했음.

- MLP 결과와 유사하게, LRP-a-b는 다른 기여도 방법들과 비교했을 때 이례적인 결과를 보였음.

- CNN의 경우 DeepSHAP의 충실성 스킬이 감소했으며, 이는 이론적 주장 및 다른 연구 결과와 모순됨. CNN이 필터 기반 아키텍처에 따라 더 군집된 패턴을 학습하기 때문에 이러한 결과는 DeepSHAP의 이론적 정의와 특징 간 상관성에 대한 취약성으로 인한 것으로, 후자는 partitionSHAP이 더 적합한 옵션임을 시사함. - (Complexity) 복잡성 측면에서, 기여도 방법은 네트워크 전반에서 민감도 방법에 비해 약간의 스킬 향상을 보였으나, CNN의 LRP-a-b는 예외였음. 이는 특징의 관련성을 무시하는 것이 CNN의 설명에서 더 중요한 영향을 미쳐 설명에서 뚜렷한 특징이 더 적어짐을 나타내며, DeepSHAP의 낮은 스킬은 CNN에 대한 DeepSHAP의 단점을 다시 한번 확인시켜줌.

- (Localization) MLP와 CNN 모두 전반적으로 낮은 스킬 점수를 보였음. 이는 ROI의 크기나 위치가 사례 연구에 최적화되지 않았음을 나타냄. 그럼에도 불구하고, XAI 방법 전반의 스킬 점수는 복잡성 결과와 일치하지만 최저 및 최고 스킬 점수에서는 차이가 있음. LRP 복합 규칙은 가장 낮은 위치화 스킬을 보여, 충실성과 해석 가능성 간의 트레이드오프를 ROI에서도 확인시켜줌. FusionGrad는 CNN에서 가장 높은 위치화 스킬을 제공하는 반면, LRP-a-b는 MLP에서 가장 높은 스킬을 기록했지만 CNN에서는 두 번째로 낮은 스킬 점수를 기록했음. 복잡성과 위치화에서 네트워크 간 결과 차이는 학습된 패턴의 차이(위에서 논의된 대로)로 인한 것으로, 이는 설명에서 증거의 공간적 분포를 평가하는 속성에 영향을 미침.

- (Randomiztion) 네트워크에 상관없이 민감도 방법이 기여도 방법보다 더 우수한 성능을 보였으며, 이는 네트워크 매개변수의 변화에 대한 민감도가 감소했음을 나타냄. 약간 낮긴 하지만, DeepSHAP의 랜덤화 스킬 점수는 다른 기여도 방법과 일치하여 이전 연구와 일치함.

- 종합적으로, 우리의 결과는 다른 네트워크 아키텍처에 적용된 설명 방법이 Faithfulness 과 Randomization 속성에서는 유사한 성능을 유지하지만, Robustness, Complexity and Localization 속성은 특정 아키텍처에 따라 달라진다는 것을 보여줌.

4.4. Choosing an XAI method

- 실무자들은 자신의 네트워크 작업에 필수적인 설명 속성을 결정해야 함.

- 예를 들어, 물리적으로 정보가 포함된 네트워크의 경우, 매개변수의 중요성 때문에 연속적인 랜덤화에 설명이 반응해야 하므로 랜덤화(모델 매개변수 랜덤화 테스트)가 중요함.

- 마찬가지로, ROI(관심 영역)를 사전에 결정할 수 없는 경우에는 위치화가 덜 중요할 수 있음. - 실무자들은 다양한 XAI 방법에 걸쳐 각 선택된 속성에 대한 평가 점수를 계산함. (스킬 점수 사용)

- 스킬 점수 혹은 설명 방법의 순위를 기준으로 최적의 XAI 방법 선택.

- 강한 Robustness, Faithfulness 희생하지 않으면서, 간결 특징(Complexity), network parameters 에 대한 Randomization, 포착 필요함.

- Quantus XAI 평가 라이브러리1) 사용 -> MLP에 대한 평가 Spider Plot

- High Robustness, But Randomization, Localization, Complexity, Faithfulness 차이 有

- 본 연구선 MLP 설명을 위한 LRP-z 선택.

- 북대서양 지역 및 냉각 패턴 의존 네트워크

- 강력한 Randomization skill 제공하는 Sensitivity methods (SmoothGrad) 추가 적용시, 네트워크 결정의 추가 측면 설명 가능.

5. Discussion and conclusions

- 적정 XAI 방법 선택시 도움을 줄 수 있는 XAI 평가 프레임워크 제안.

- skill score 비교 및 explanation 순위 통한 XAI 방법 및 조합 결정 가능.

- 서로 다른 네트워크서 서로 다른 explanations, 다양한 강점 및 약점

- 각 연구별 XAI 방법 선택에 있어 XAI 평가 도움.